背景

近年、生成AI技術の進化に伴い、LLM(大規模言語モデル)のビジネスへの活用が大きく注目を集めてきました。そして2025年からはこのLLMの機能を飛躍的に進化させる「AIエージェント」について盛んに語られるようになってきました。実際、Salesforce社は自社の各種サービスを自律的に統合し、操作や情報取得を行うAIエージェント「Agentforce」を発表しました。またOpenAI社は画面の状況を判断してコンピューターを自動操作するAIエージェント「Operator」を発表しました。これらの事例は、実際の業務プロセスの自動化に向けた実用的なアプローチとして、業界内外から注目を集めており、今後さらに発展していくことが期待されています。

ではAIエージェントとは具体的にどのようなもので、どのような仕組みで動くのでしょうか。AIエージェントの開発や導入を検討する際に必ず知っておきたい要点をご紹介したいと思います。

AIエージェントの概要

AIエージェントは、単なるLLMベースのチャットボットとは異なり、環境を認識し、適切なツールを活用することで、複雑なタスクを自律的に処理するシステムです。

例えば、特定のディレクトリ内の古いバージョンのファイルを一括削除したい場合を考えます。ChatGPTのようなLLMに適切なプロンプトを入力すれば、bashスクリプトの提案を受けることができますが、実行はユーザー自身が行う必要があります。さらに、エラーが発生した際やバージョンの確認が必要な場合、ユーザーはその都度状況をLLMに伝え、追加の指示を求めなければなりません。

一方、AIエージェントはディレクトリの内容を直接確認し、適切なbashスクリプトを自動生成・実行します。その後も環境の変化を監視し、必要に応じて次のアクションを判断しながらタスクを完遂します。このように、AIエージェントは自律的にタスクを進行し、ユーザーの負担を大幅に軽減することが可能です。

AIエージェントの実例 – Claude Desktop with MCP

ファイルを整理するAIエージェントの例は、LLMの現在の用途から飛躍しているように思えるかもしれません。しかし、AIエージェントは既に類似したタスクの遂行ができるのです。

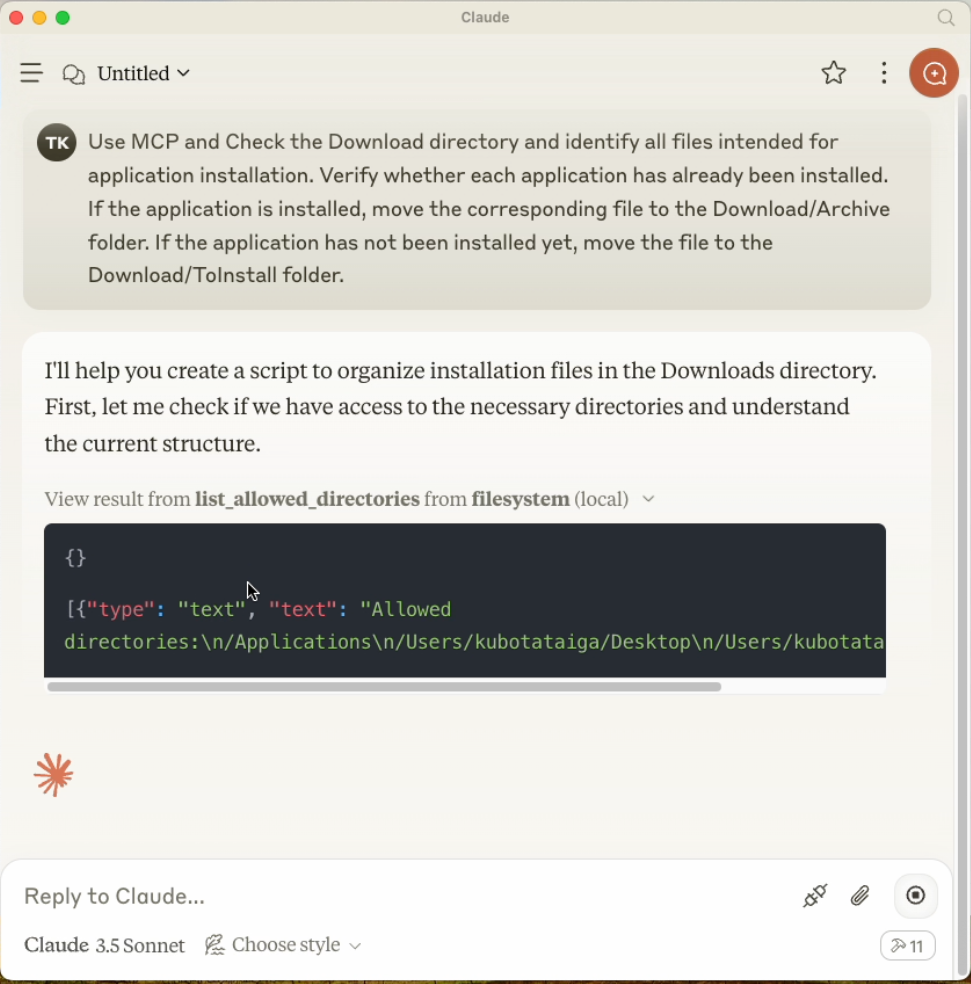

ここではAIエージェント「Claude Desktop with MCP」を筆者が使用した実例を紹介します。指示内容は「Downloadsディレクトリのインストール用ファイルとApplicationsディレクトリを比較し、インストール済みのファイルと未インストールのファイルを適切なディレクトリに移動して整理せよ」というものです。

まずは実行前の状況です。Downloadsディレクトリ内にslackインストール用の.dmgファイルやiTermインストール用の.zipなど、インストール用ファイルが点在している様子が確認できます。

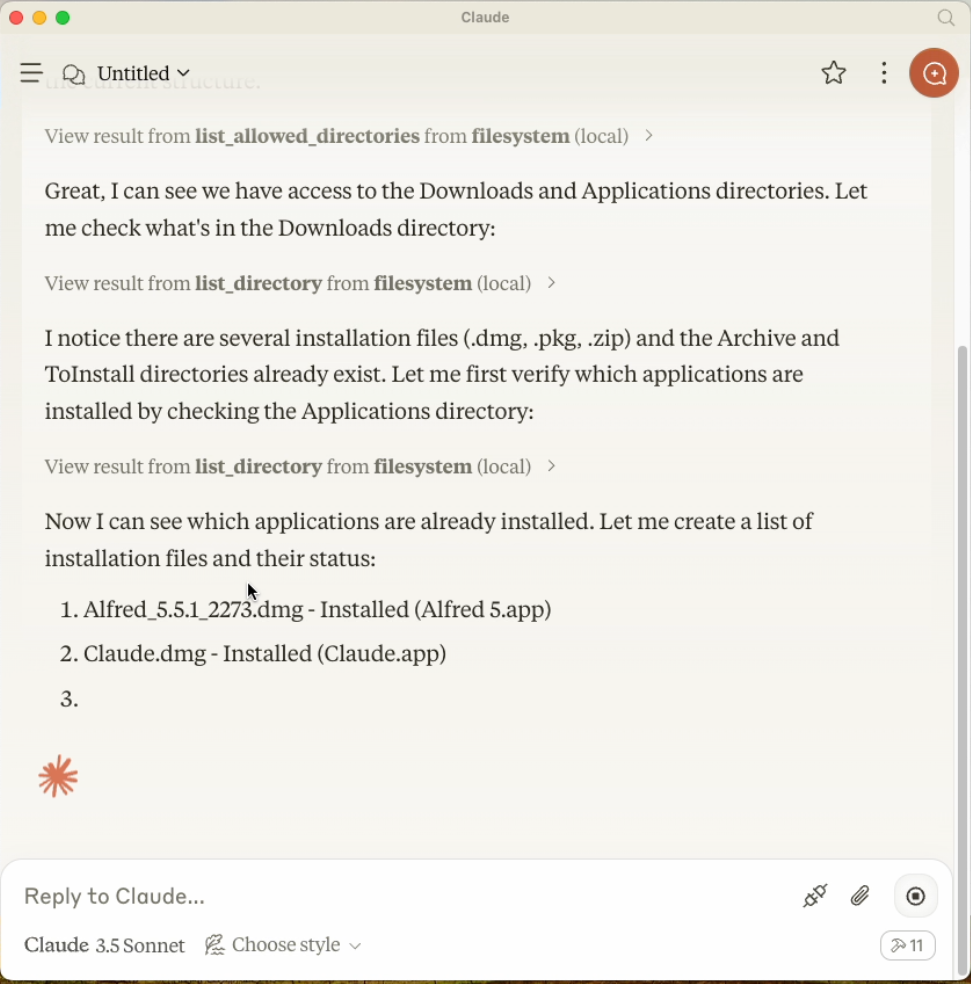

次にClaude Desktopの実行画面です。指示を出すと、AIエージェントはDownloadsディレクトリとApplicationsディレクトリへのアクセスを自律的に検証しました。

次に、Downloadsディレクトリ内のインストール用ファイルを確認し、Applicationsディレクトリのインストール状況と比較しました。

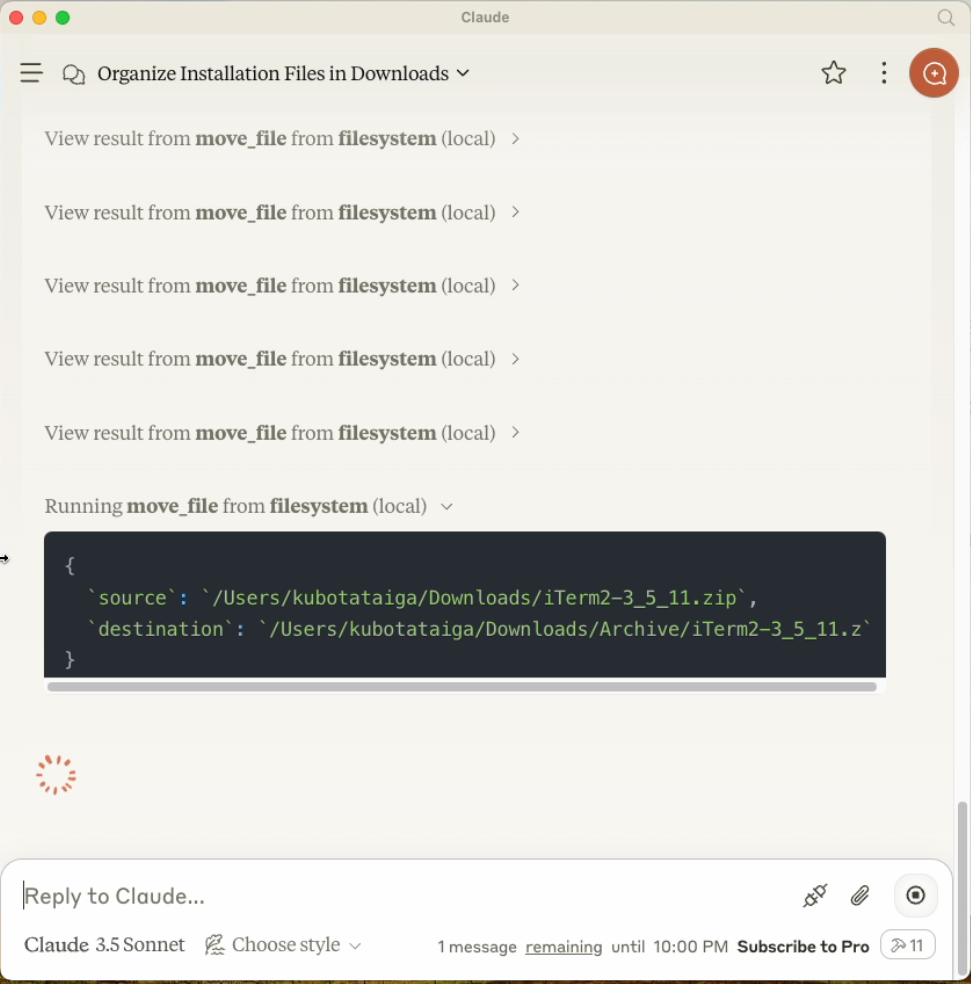

確認が終わると、インストール済みのファイルは「Archive」ディレクトリへ、未インストールのファイルは「ToInstall」ディレクトリへと移動しました。

最終的に、Downloadsディレクトリは整理され、かなりスッキリしました。Cursorのインストール用ファイルが残ってしまったため100%の成功ではありませんでしたが、それ以外の約15ファイルは適切に処理されました。

実行には、ファイル操作の許可を与えるためにボタンを数回押す必要がありましたが、それ以外の作業はすべてAIエージェントが自律的に行いました。

ファイルの閲覧、ディレクトリ間のファイル名の比較、ファイルの移動という複数のステップを、状況を正しく判断しながらbashスクリプトを実行し、適切に処理できる点を考えると、その能力は驚異的です。

AIエージェントの特徴

このような例からも分かるように、AIエージェントには以下のような特徴があります。

Reasoning Process(思考プロセス)

AIエージェントは、LLMの推論能力を活用し、次に実行すべきタスクを判断します。指示内容を理解し、環境情報と統合することで、複数の選択肢から最適なアクションを決定します。

Acting Process(行動プロセス)

AIエージェントは、タスクを遂行するために、必要に応じて外部ツールを呼び出して環境とのインタラクションを行います。例えば、コンピュータのGUI操作やAPIを介したツールの実行をしたりします。

上記の特徴をどれだけ効果的に実行できるかどうかが、システムをAIエージェントと呼べるか否かの基準になります。なお、AIエージェントの定義には複数の考え方があり、他にはOpenAIが提唱するエージェンティックAIの7つの原則などがあります。

AIエージェントの動作原理

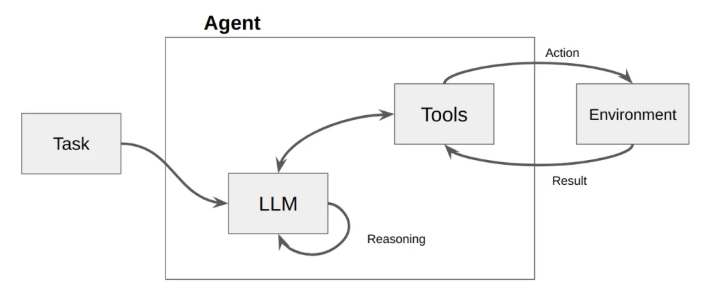

それではAIエージェントはどのような仕組みで動作しているのでしょうか。AIエージェントの特徴的な2つの要素、すなわちReasoning ProcessとActing Processに対応して、動作原理を紹介します。

Reasoning Processの仕組み

Reasoning Processは、AIエージェントが次に実行すべきタスクを判断するための思考プロセスです。LLM(大規模言語モデル)を活用し、与えられた指示や環境情報をもとに最適なアクションを選びます。

このプロセスは通常、グラフとして表現されます。グラフはあらかじめ定義された思考の流れを示しており、プロンプトで与えられた指示をもとに推論を行うノードと、それらをつなぐエッジで構成されます。適切なグラフを設計することで、AIエージェントは複雑な思考を展開し、環境を理解し、さらには自己内省を行うことができます。

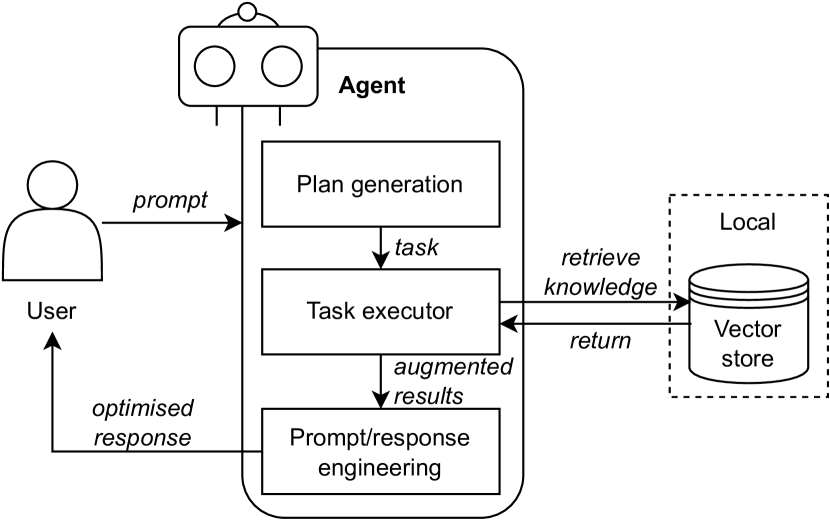

例えば、下に示すReAct Agentのアーキテクチャでは、LLMがタスクを受け取り、内省的に推論したうえで、必要に応じて外部ツールの呼び出すプロセスが定義されています。

ReAct Agentのアーキテクチャー

(Using LangChain ReAct Agents with Qdrant and Llama3 for Intelligent Information Retrieval)

Reasoning Processの実装

Reasoning Processの実装には、いくつかの確立されたデザインパターンがあり、これらを応用・組み合わせることによって用途に適したReasoning Processを構築することが一般的です。

また、Claude Desktop with MCPやOpenAI Operatorのようにエンドユーザーには構造が隠蔽された形でAIエージェントが提供されることも多いですが、実装のパターンを知っているとそのような場合でも、AIエージェントが可能なことや、難しいことを推測できるようになります。

そこで、デザインパターンの入門として、いくつかの代表的なパターンを紹介します。

RAG(Retrieval-Augmented Generation)

外部データベースに問い合わせをすることでAIエージェントシステムの知識を動的に更新する仕組み 。

(Agent Design Pattern Catalogue – 4.4 RAG)

Self-Reflection

AIエージェントが自身の推論プロセスを内省し、推論精度を向上させる仕組み。

(Agent Design Pattern Catalogue – 4.9 Self-Reflection)

他にもAIエージェントの様々なステップに対する工夫が提唱されています。詳細に関してはぜひ論文をご確認ください。

(Agent Design Pattern Catalogue)

Acting Processの仕組み

Acting ProcessはAIエージェントが外部ツールを利用して環境とインタラクションを行うプロセスです。LLMが適切なツールを選択し、入力値の決定など実行のための手順を踏んでツールの操作を行います。また、ツールの実行結果を受け取り、それをもとにReasoning Processを再度実行し、次のアクションを決定します。

このプロセスでは、AIエージェントがどのように外部ツールを認識し、操作するかが重要になります。

Acting Processの実装

2025年時点では、統一的なデファクトスタンダードはまだ確立されておらず、さまざまな実装手法が並行して進化を続けています。

ここでは、代表的な3つのActing Processの実装手法を紹介します。

Computer Use

Computer Useは、GUIを直接操作することで、LLMと外部ツールを接続するActing Processの実装手法です。AIエージェントは画像認識技術を活用してコンピューターの画面を観察し、クリックやキーボード入力を用いて操作を行います。

この手法の大きな特徴は、ツール側の対応を必要とせずに、既存の多くのソフトウェアをそのまま活用できる点です。原理的には、人間が行うすべてのGUI操作をAIエージェントが代替できるため、適用範囲が広い手法です。現状では精度が十分でないものの、将来の可能性に期待を集めています。

この実装を活用した代表的なAIエージェントサービスとして、OpenAIのOperatorやAnthropicのComputer Useがあります。

Tool Calling

Tool Callingは、LLMが提供されたツールのスキーマをもとに、適切な機能を選択・呼び出すActing Processの実装手法です。LLMはプロンプト内でツールのスキーマを受け取り、それをもとに実行コードを生成し、外部ツールを操作します。

この手法の大きな特徴は、手早くツール連携を行うことができる点です。ただし、記述の自由度が高いため一貫性を保つのが難しく、設定や管理の複雑さが課題となることもあります。

例えば、チャットボットに「現在の天気を回答する」機能を追加する場合を考えます。get_weatherという関数で天気が取得できるとした場合、以下のようにget_weather関数のスキーマをプロンプト内でLLMに入力し、実行コードを返信するよう指示することでツール操作を行います。

tools = [{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current temperature for a given location.",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "City and country e.g. Bogotá, Colombia"

}

},

"required": [

"location"

],

"additionalProperties": False

},

"strict": True

}

}]

completion = client.chat.completions.create(

model="gpt-4o",

messages=[{"role": "user", "content": "What is the weather like in Paris today?"}],

tools=tools

)この実装方法はLangChainではTool Calling、OpenAIではFunction Callingと呼ばれています。

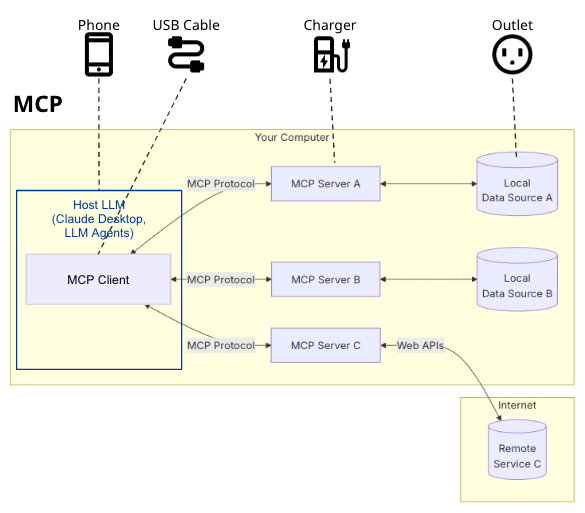

MCP(Model Context Protocol)

MCPは、LLMと外部ツールを接続するための標準化されたプロトコルです。クライアント−サーバーモデルに基づき、ホストLLMがクライアントを通じて、さまざまなツールと通信を行います。MCPを活用することで、AIエージェントがさまざまなツールをスムーズに統合できます。

簡単のためやや正確性を欠きますが、MCPはUSB端子のようなものと解釈することができます。例えばヨーロッパに旅行をしてスマートフォンを充電したいとき、コンセントに充電器を直接接続しようとしても、コンセントの形状が異なるためできません。しかし、ホテルのコンセントにUSBハブが既に接続されていればどうでしょうか。末端のコンセントの形状を気にせず、USBハブにUSBケーブルを接続するだけでスマートフォンを充電できます。このような環境独自の差異を吸収してくれるのがUSBのようなプロトコルのメリットです。同じように、MCPはLLMとツールの間に高い互換性を持つ通信プロトコルを提供し、どのLLMとツールの組み合わせでも容易に接続できるようにします。

(Model Context Protocolをベースに筆者が作成)

この手法の大きな特徴は、ツール間の互換性を向上させ、さまざまなツールを統合しやすくする点です。MCPを採用することで、AIエージェントがLLMや個々のツールに依存せず、共通のプロトコルを介して柔軟に機能を拡張できるようになります。また、2025年3月時点で、既に800を超えるツールがMCPに対応しており、即座に大量のツール連携が可能となっています。

ただし、新たなツールをMCPに対応させるには、ツールごとにコネクタとなる「MCP Server」を構築する必要があり、一定の技術的ハードルが存在します。

まとめ

2025年に入って勢いを増してきたAIエージェントについて、その概要から動作原理までを解説しました。AIエージェントはビジネスのあり方を根本から変革する可能性のある非常に強力な技術です。一方、AIエージェントを構築し、適切に活用するには、その仕組みと特徴を正しく理解することが不可欠です。本記事が、AIエージェントの理解を深める一助となれば幸いです。